计算机行业专题报告:豆包大模型更新至1.5pro,更真实、更懂你

AI智能总结

AI智能总结

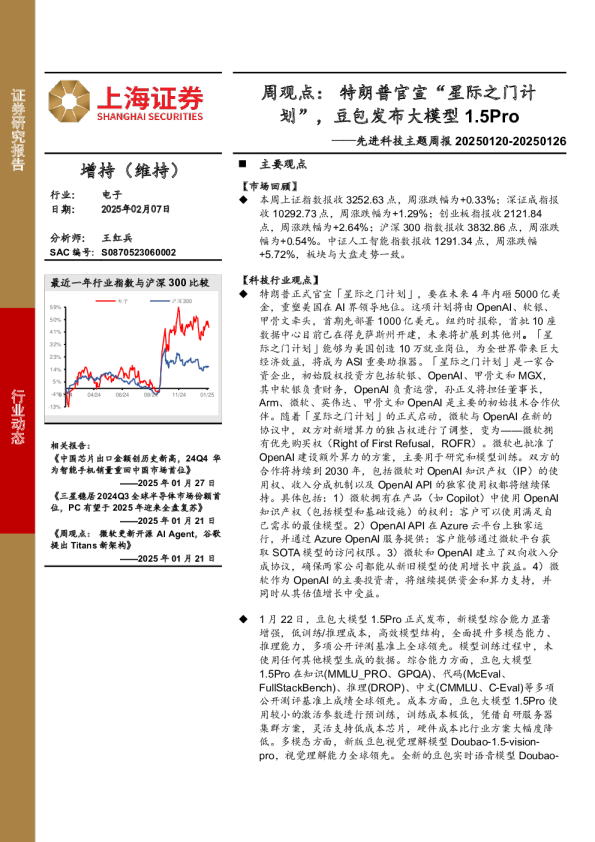

Doubao-1.5-pro实现7倍MoE性能杠杆,同时推理成本仅为GPT-4o的10%。Doubao-1.5-pro采用MoE(混合专家)架构,通过训练—推理一体化设计,保证模型性能的同时尽量降低推理成本,Doubao-1.5-pro-32k的千tokens输入单价为0.0008元,大约为GPT-4o-0806批量版本(千tokens输入单价0.00125美元)的10%。豆包通过模型结构调优以及训练算法优化,实现7倍MoE性能杠杆,针对Prefill/Decode与Attention/FFN四个象限,采用异构硬件结合不同的低精度优化策略,在确保低延迟的同时大幅提升吞吐量,在降低总成本的同时兼顾TTFT和TPOT的最优化目标。 视觉、语音多模态能力全面提升。Doubao-1.5-vision-pro在多模态数据合成、动态分辨率、多模态对齐、混合训练上进行了全面的技术提升,高效的原生动态分辨率训练,提升模型文档识别、细粒度信息识别能力。Doubao-1.5-realtime-voice-pro,语音语义联合建模实现语音理解和生成一体化,打破传统“ASR+LLM+TTS”级联限制,实现降低延迟,并达到真人级语音水准。 豆包情感语音功能落地移动端,图灵测试“终结者”。2025年1月20日,豆包实时语音大模型落地移动端,做到语音理解和生成一体化,实现了端到端语音对话。相比传统“ASR+LLM+TTS”级联模式,在语音表现力、控制力、情绪承接方面表现惊艳,并具备低时延、对话中可随时打断等特性。根据外部用户真实反馈,该模型整体满意度较GPT-4o有明显优势,特别是语音语气自然度和情绪饱满度远高于后者。在此之前,大模型以AI搜索的形式触达到大部分的网民,但对于不识字或不常打字的人群来说AI仍较为陌生,豆包实时语音大模型以超拟人化的形式融入广大人民的生活当中,大模型应用触达人群将从中青年迅速向幼年与老年人群扩散,AI也从“办公助手”扩散至“生活助手”,打开诸如聊天娱乐、教学陪练、心理疏导、查询播报等新的AI应用空间。 投资建议:当前产业阶段,建议关注和豆包Capex紧密度最强的AI硬件环节龙头厂商,如海光信息、寒武纪、润泽科技、英维克、欧陆通、协创数据、中科曙光、浪潮信息、曙光数创、高澜股份、英伟达(NVDA.O)、博通(AVGO.O)、迈威尔科技(MRVL.O)等,以及和字节可能持续推进产业合作的B端软件公司,如新致软件、汉得信息、法本信息、亚信安全、四维图新等,同时豆包大模型情感能力提升会进一步强化陪伴类场景的落地,建议关注乐鑫科技、润欣科技、移远通信等。 风险提示:技术迭代不及预期;商业化落地不及预期;政策支持不及预期; 全球宏观经济风险。 1Doubao-1.5-pro基础能力全面提升 Doubao-1.5-pro采用MoE(混合专家)架构,通过训练—推理一体化设计,保证模型性能的同时尽量降低推理成本。2025年1月22日,豆包底层大模型更新至Doubao-1.5-pro(包括文本、视觉、实时语音、推理等多个专家模型),其仅用较小的激活参数,即可超过一流超大稠密预训练模型的性能,并在多个评测基准上取得优异成绩,在知识、编码、中文方面形成明显优势。 图1.Doubao-1.5-pro在多个基准上的测评结果 严控推理成本,版本升级价格不变。Doubao-1.5-pro-32k的千tokens输入单价为0.0008元,千tokens输出单价为0.002元,与Doubao-pro版本保持一致。其价格大约为GPT-4o-0806批量版本(千tokens输入单价0.00125美元)的10%,豆包在保障性能的同时,具备显著价格优势,加速国内企业接入国产大模型API服务。 图2.Doubao-1.5-pro输入输出价格 高效MoE模型,平衡模型性能和推理成本 从训练和推理效率的角度出发,Doubao-1.5-pro使用稀疏MoE架构。在预训练阶段,仅用较小参数激活的MoE模型,性能即可超过Llama3.1-405B等超大稠密预训练模型。团队通过对稀疏度ScalingLaw的研究,确定了性能和效率比较平衡的稀疏比例,并根据MoEScalingLaw确定了小参数量激活的模型即可达到世界一流模型的性能。 在预训练模型基础上,算法团队还设计了一系列模型参数动态调整算法。可以基于具体应用对模型性能的需求,从模型深度、宽度、MoE专家数、激活专家数、隐藏token推理等不同维度,对模型参数进行扩增和缩小,达到模型能力和推理成本的最优平衡。 图3.Doubao-Dense和Doubao-MoE的训练loss图 研究MoE模型的ScalingLaw,以便在预训练前确定最优参数设置。通常密集型模型的训练计算资源预算使用公式C = 6ND来估算,其中N表示参数数量,D表示训练数据的tokens数量。然而,对于具有更长序列(例如8K、32K和256K)的MoE模型,由于注意力机制的复杂性和稀疏激活,计算资源预算公式会变为:C≈9.59ND + 2.3 × 10D。据此,在不同的计算量下,研究随着激活参数的变化,训练损失的收敛情况,由此确定最优的激活参数与预训练tokens数量。 图4.利用二次多项式拟合,获得不同最小计算预算下激活参数最优数量的ScalingLaw 豆包通过模型结构调优以及训练算法优化,实现7倍MoE性能杠杆。MoE模型的性能通常可以用表现相同的稠密模型的总参数量和MoE模型的激活参数量的比值来确定,比如IBM的Granite系列模型中, 800M 激活的MoE模型性能可以接近2B总参数的稠密模型,性能比值大约在2.5倍,业界在这一性能杠杆上的普遍水平为不到3倍。豆包团队通过模型结构和训练算法优化,在完全相同的部分训练数据(9Ttokens)对比验证下,用激活参数仅为稠密模型参数量1/7的MoE模型,超过了稠密模型的性能,将性能杠杆提升至7倍。 Doubao-Dense和Doubao-MoE均为9T tokens的数据的阶段性结果,数据分布完全相同;MoE模型的性能略优于参数量为MoE激活参数量7倍的稠密模型。 Llama3.1-405B为15Ttokens的最终结果,数据分布和Doubao模型不同,Doubao稠密模型的参数量也远小于Llama3.1-405B,从结果上可以看到Doubao预训练的数据质量和训练超参更优;MoE模型完整训练后的性能比9T tokens数据的中间版本有更大提升。 图5.Llama3.1、Doubao-MoE和Doubao-Dense的Performance对比图 Doubao-1.5-pro是一个高度稀疏的MoE模型,在Prefill/Decode与Attention/FFN构成的四个计算象限中,表现出显著不同的计算与访存特征。豆包针对四个不同象限,采用异构硬件结合不同的低精度优化策略,在确保低延迟的同时大幅提升吞吐量,在降低总成本的同时兼顾TTFT(Time To First Token,输入到输出首个token的延迟)和TPOT(Time Per Output Token,每个输出token的延迟)的最优化目标。 针对Tensor(张量)传输进行定制化的RPCBackend(远程过程调用底层系统),并通过零拷贝、多流并行等手段优化了TCP/RDMA(传输控制协议/远程访问内存)网络上的Tensor传输效率,进而提升PD分离(模型参数与训练数据分开存储和管理)下的KVCache(键-值缓存)传输效率。 支持Prefill(初始阶段)跟Decode(解码阶段)集群的灵活配比和动态扩缩,对每种角色独立做HPA(Pod水平自动伸缩器)弹性扩容,保障Prefill和Decode都无冗余算力,两边算力配比贴合线上实际流量模式。 在框架上将GPU计算和CPU前后处理异步化,使得GPU推理第N步时CPU提前发射第N+1步Kernel,保持GPU始终被打满,整个框架处理动作对GPU推理零开销。 凭借自研服务器集群方案,灵活支持低成本芯片,硬件成本比行业方案大幅度降低。豆包还通过定制化网卡和自主研发的网络协议,显著优化了小包通信的效率。 在算子层面,豆包实现了计算与通信的高效重叠(Overlap),从而保证了多机分布式推理的稳定性和高效性。 图6.不同阶段的计算和访存特征 豆包在数据、算法、模型层面全面实现了Scaling,完成算力到智力的有效转换。 (1)在Post Training阶段,豆包通过高效标注团队与模型自提升技术的深度融合,构建高度自主的数据生产体系,数据标注“不走捷径”,不使用任何其他模型的数据,确保数据来源的独立性和可靠性;(2)Reward Model部分,构建了统一的Reward框架,实现了模型在数学、编程、知识、对话等多维度能力的均衡提升; (3)RL阶段,基于veRL(变分嵌入强化学习)打造了高并行化的多角色训练推理一体框架,兼容不同类型的数据和奖励方式;(4)通过自适应数据分布调节机制,解决了多任务训练中的冲突问题;(5)攻克了价值函数训练难点,实现token-wise稳定建模,收敛速度提升4倍,在高难度任务上的性能提升超过10个绝对点;(6)通过对比学习方法,有效提升了LLM的表现并显著缓解了reward hacking问题(智能体通过非预期的、不希望的方式来最大化奖励)。 依托字节在推荐、搜索和广告领域的AB Test经验,研发了基于用户反馈的高效PostTraining全流程。基于豆包的大规模用户反馈,构建了从问题发现、数据挖掘、人机结合标注到快速迭代的闭环优化系统,通过用户数据飞轮持续提升模型的实际使用体验。 多模态能力全面提升 1.2.1视觉多模态:性能进一步提升,从容应对更复杂场景 Doubao-1.5-vision-pro在多模态数据合成、动态分辨率、多模态对齐、混合训练上进行了全面的技术提升。新版本进一步增强了模型在视觉推理、文字文档识别、细粒度信息理解、指令遵循等方面的能力,并让模型的回复模式变得更加精简、友好。在同一模型中融入强大的视觉理解能力,使模型可以同时理解虚拟和现实世界的各类视觉信号,更好地辅助人类决策。 高效的原生动态分辨率训练,提升模型文档识别、细粒度信息识别能力。分辨率问题一直是影响视觉理解能力的关键因素,尤其在虚拟世界中,信息理解受分辨率的影响更为明显。为应对各类场景下的复杂图像输入,Doubao-1.5-pro采用了原生动态分辨率架构设计,支持任意分辨率的图像输入。无论是高清大图还是低分辨率的小图,亦或是极端长宽比例的图像,模型都能实现精准的特征提取和高效的计算性能。借助于原生分辨率的设计,新模型在文档识别、细粒度信息识别等任务上实现了极大的效果提升。豆包自研的支持动态分辨率的DoubaoViT在多种视觉分类任务中表现优异,仅凭2.4B规模便在综合评分上取得SOTA表现,效果超越7倍于自身规模的模型。 图7.Doubao-1.5-pro在多个视觉基准上的测评结果 图8.Doubao ViT在多种视觉分类任务中的表现 图9.豆包支持任意分辨率和极端长宽比图像识别以及复杂指令遵循能力 1.2.2语音多模态:通过语音语义联合建模,打破传统“ASR+LLM+TTS”级联限制 “ASR+LLM+TTS”仍为当前大多语音生成模型采用的技术路线,技术成熟度高但延迟问题严重。ASR负责将语音准确转换为文本,LLM对文本进行理解、推理和生成等复杂处理,TTS再将生成的文本转换为自然流畅的语音,从而实现从语音输入到语音输出的完整交互功能,目前已在智能客服、语音助手等场景实现广泛应用。但由于多步骤级联,使得语音模型反馈延迟较大,交互体验感较为一般。 ASR(Automatic Speech Recognition,自动语音识别)能够将人类的语音转换为计算机可以理解和处理的文本,通过分析和处理音频信号,识别其中的语音内容,并将其转化为文字输出。 LLM对海量文本数据进行训练,从而使得模型具备理解和生